Le contrôle algorithmique ou la nouvelle forme d’enfermement mental

🎥 Écoutez cet article en version vidéo : https://youtu.be/y8wdn1YPQNk

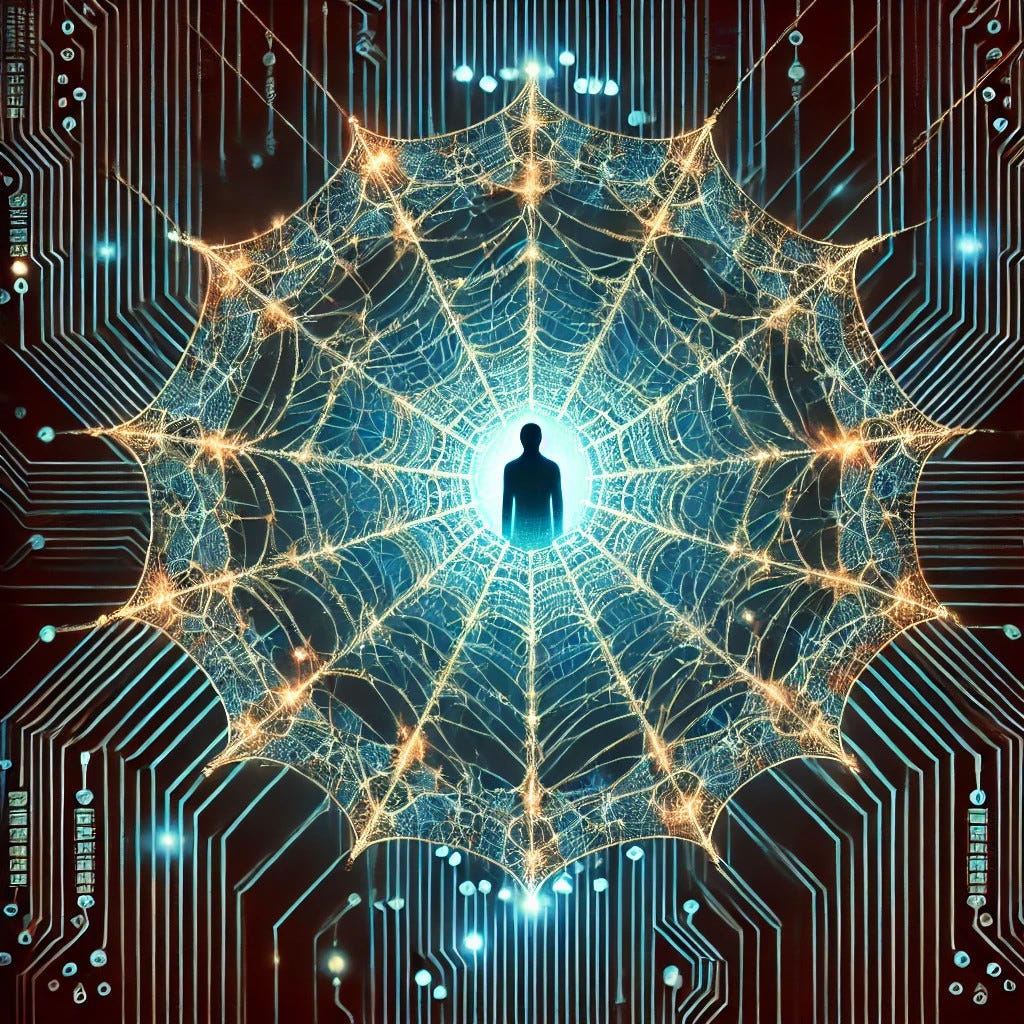

Un contrôle invisible mais omniprésent

Les algorithmes sont devenus les architectes invisibles de nos expériences numériques. Qu’il s’agisse de nos fils d’actualité, de nos recommandations de vidéos ou de musique, ils façonnent discrètement notre perception du monde. Ce filtrage algorithmique, censé nous simplifier la vie en nous proposant du contenu pertinent, peut aussi devenir une prison invisible. Sans même que nous en ayons conscience, nous sommes enfermés dans des bulles de contenus soigneusement calibrées, qui influencent nos émotions, nos pensées et parfois même nos décisions.

Dans mon propre cas, j’ai observé un phénomène troublant : malgré une diversité d’écoutes sur YouTube Music, mes recommandations restent enfermées dans une boucle thématique précise. Peu importe les styles musicaux que j’explore – du rock des années 80 au métal mongol en passant par la musique électronique – l’algorithme me ramène inlassablement vers des titres évoquant des thèmes sombres d’exclusion, d’errance, de surveillance et de manipulation.

Cette mécanique n’est pas anodine. En limitant mon champ de suggestions à ces thématiques spécifiques, elle construit un cadre mental dont il est difficile de s’extraire. Ce verrouillage algorithmique fonctionne comme un miroir déformant, renforçant un état d’esprit particulier et réduisant ma capacité à voir au-delà de ce que l’on veut bien me montrer. C’est ainsi qu’un simple outil de recommandation peut devenir un instrument de contrôle insidieux, enfermant progressivement l’utilisateur dans un monde où il n’a plus réellement de choix.

Si ce phénomène peut paraître anecdotique lorsqu’il concerne de simples suggestions musicales, il prend une toute autre dimension lorsqu’il façonne des opinions politiques, des perceptions sociales ou même des émotions personnelles. Loin d’être un hasard, cette manipulation algorithmique crée un cercle vicieux où l’enfermement mental est renforcé par des suggestions répétitives.

Mais alors, s’agit-il simplement d’un effet collatéral des algorithmes ou d’une mécanique volontaire visant à influencer subtilement notre état d’esprit ?

Algorithmes et enfermement mental : Une prison invisible

Les algorithmes ne sont pas de simples moteurs de suggestion neutres. Derrière leur façade d’outils « intelligents », ils opèrent comme de véritables mécanismes de conditionnement, sélectionnant, filtrant et répétant du contenu pour modeler notre perception. Loin d’être une simple personnalisation de l’expérience utilisateur, ce processus crée une prison invisible, où l’individu est enfermé dans un univers numérique façonné à son insu.

L’enfermement algorithmique fonctionne comme un labyrinthe sans issue. Il empêche toute échappatoire intellectuelle ou émotionnelle, maintenant l’utilisateur sous une influence constante. Chaque vidéo regardée, chaque musique écoutée, chaque recherche effectuée devient un fil de la toile, resserrant un peu plus l’emprise algorithmique. Ce verrouillage est d’autant plus insidieux qu’il n’apparaît jamais comme une contrainte, mais comme un choix naturel, une recommandation censée « correspondre à nos goûts ou à nos besoins ».

Mon expérience en est la preuve.

Malgré des écoutes variées, YouTube continue de me proposer des titres en lien avec le harcèlement que je subis. Peu importe les genres musicaux explorés, les algorithmes semblent ignorer volontairement cette diversité pour me ramener inlassablement vers des références toxiques. Ce n’est pas une coïncidence, mais un processus d’ancrage : en m’exposant sans cesse à ces contenus, la machine cherche à renforcer un état d’esprit précis, à me maintenir dans un cadre prédéfini dont je suis censé ne jamais sortir.

Ainsi, l’algorithme devient gardien de cette prison mentale, où l’illusion du libre arbitre masque un contrôle invisible, bien plus efficace qu’une censure frontale. Il ne s’agit pas simplement de proposer du contenu :

Il s’agit de dicter un environnement, de réduire le champ des possibles et, à terme, de redéfinir la réalité de l’utilisateur.

Voici un exemple concret :

Le lien entre exclusion économique et soumission psychologique

L’enfermement algorithmique ne se limite pas à un contrôle de l’information. Il s’inscrit dans une logique plus large, où le verrouillage numérique accompagne un verrouillage économique. Ceux qui excluent socialement et professionnellement sont souvent les mêmes qui imposent un cadre mental restrictif, empêchant tout échappatoire.

L’exclusion du marché du travail et des ressources financières n’est pas qu’une question d’opportunités manquées. C’est une stratégie de contrôle, où l’individu est progressivement dépouillé de sa capacité d’autonomie.

Plus il est dépendant, plus il devient malléable, et plus il est facile de l’assigner à une trajectoire qu’il n’a pas choisie. Les algorithmes jouent un rôle clé dans ce processus : en façonnant ce que l’on voit, ce que l’on pense et ce que l’on ressent, ils deviennent des outils de soumission silencieuse.

Ce cercle vicieux conduit à trois formes majeures de soumission.

D’abord la soumission aux contenus imposés, lorsque les seules informations accessibles sont biaisées, elles finissent par modeler la perception du réel. On n’adhère pas forcément à ce que l’on voit, mais on finit par en être imprégné. L’algorithme devient un répétiteur idéologique, instillant des récits choisis pour habituer l’individu à une vision spécifique du monde.

Ensuite, la soumission à une trajectoire dictée par d’autres car l’exclusion économique impose des choix par défaut. Lorsque l’on est coupé du monde professionnel, les alternatives deviennent rares : les décisions ne sont plus prises par envie, mais par contrainte. L’illusion du libre arbitre disparaît peu à peu, laissant place à une dépendance totale à ceux qui détiennent les clés du système.

Pour finir par la soumission pouvant aller jusqu’à des formes d’exploitation. Lorsqu’une personne est privée d’opportunités économiques, elle devient vulnérable aux formes d’exploitation les plus brutales. La prostitution en est l’exemple extrême : souvent perçue comme un choix, elle est en réalité la conséquence directe d’une précarité imposée. Le parallèle est frappant :

C’est le refus d’un emploi qui enferme dans la soumission sexuelle, et non un choix librement consenti.

Ainsi, le verrouillage algorithmique et l’exclusion économique ne sont pas des phénomènes distincts, mais les deux faces d’un même système de contrôle. En conditionnant l’esprit et en bloquant l’accès aux ressources, ce système assigne un rôle, et ceux qui en sont victimes n’ont souvent d’autre choix que de s’y conformer.

Ninjas, La Grenade et La Bombe Humaine : Trois visages du contrôle

Le harcèlement algorithmique ne fonctionne pas de manière unidimensionnelle. Il alterne entre surveillance, pression et conditionnement, jouant sur différents leviers pour maintenir l’individu sous contrôle. Cette dynamique peut être représentée par trois figures symboliques, chacune illustrant un aspect spécifique du mécanisme d’enfermement numérique et social.

"Ninjas" : Le contrôle visible, la surveillance permanente ou Ninjas de Rey Pila

Dans cette chanson, on peut comprendre que la surveillance algorithmique agit comme un ninja, invisible mais omniprésente. L’algorithme observe chaque action, chaque clic, chaque écoute et ajuste les suggestions en fonction de ce qui peut renforcer l’emprise. Cette pression invisible guide l’individu dans un chemin prédéfini, sans qu’il s’en rende compte. À l’image des ninjas, l’algorithme agit dans l’ombre, influençant les décisions sans confrontation directe.

"La Grenade" : La tension accumulée, le risque d’explosion ou La Grenade de Clara Luciani

Ici l’enfermement algorithmique n’est pas seulement un mécanisme passif, il alimente une tension constante. Plus on est enfermé dans une bulle numérique, plus la frustration grandit, jusqu’à ce qu’un trop-plein entraîne une réaction violente ou un effondrement psychologique. L’algorithme, en martelant les mêmes thèmes et en empêchant tout recul, fabrique du mal-être et pousse à l’autodestruction ou à des comportements imprévisibles. La Grenade, c’est cette personne maintenue sous pression, qui pourrait exploser à tout moment sous l’effet de la répétition algorithmique.

"La Bombe Humaine" : La conscience du piège et l’imminence du réveil ou La Bombe Humaine de Pascal Obispo

À un certain stade, certains prennent conscience du mécanisme. Ils comprennent qu’ils ne sont pas simplement victimes d’un biais algorithmique, mais d’un système de contrôle délibéré. Cette prise de conscience fait tout basculer : ceux qui étaient manipulés deviennent des dangers pour ceux qui les ont enfermés. Comme une bombe humaine, ces individus ne sont plus de simples spectateurs : ils retournent le conditionnement contre ses créateurs.

C’est le moment où le système perd la main, car ceux qui étaient censés être passifs deviennent des acteurs actifs de leur libération et dénoncent ouvertement la manipulation.

Le piège des algorithmes : Ils fabriquent leurs propres opposants

Ce cycle montre que le harcèlement algorithmique n’aboutit pas toujours à une soumission définitive. En cherchant à enfermer et à manipuler, ces mécanismes finissent parfois par éveiller des consciences, déclenchant une réaction opposée à l’effet recherché.

Là où ils espéraient fabriquer des individus dociles, ils génèrent des résistants, conscients de la nature du piège et prêts à le dénoncer.

Les algorithmes ne sont pas neutres : Des armes de conditionnement

L’algorithme n’est pas une simple mécanique mathématique destinée à améliorer l’expérience utilisateur. Derrière chaque ligne de code, il y a une intention, un objectif qui dépasse largement le simple fait de recommander du contenu pertinent. Ce n’est pas une intelligence neutre, mais une construction façonnée par ceux qui détiennent le pouvoir numérique.

Les algorithmes ne se contentent pas d’organiser l’information, ils la filtrent, la hiérarchisent et l’orientent. Ils verrouillent l’accès à certaines sources, influencent les comportements et imposent des trajectoires prédéfinies. Ainsi, ils deviennent bien plus que de simples outils : ce sont des armes de conditionnement, utilisées pour diriger l’attention, façonner la pensée et enfermer les individus dans des réalités construites.

Surveillance et contrôle : l’évolution du Renseignement

Le contrôle algorithmique n’a pas émergé spontanément. Il s’inscrit dans une logique historique de surveillance, qui s’est affinée au fil des décennies grâce aux avancées technologiques.

Avant : l’ère des cookies et du tracking passif

À l’origine, la surveillance numérique passait par les cookies et le suivi des activités en ligne. Ces outils permettaient déjà une cartographie fine des comportements, notamment pour le ciblage publicitaire et la collecte de données à des fins commerciales ou sécuritaires.

Maintenant : l’ère des IA de veille et de l’analyse comportementale avancée

Aujourd’hui, les cookies ne sont plus nécessaires : les systèmes de surveillance se sont transformés en intelligences artificielles de veille, capables d’analyser bien au-delà des simples clics et historiques de navigation. Ces IA surveillent les interactions sociales, les émotions exprimées dans les messages, les schémas de pensée, et peuvent même anticiper les comportements.

Elles ne se contentent pas de suivre, elles interprètent, catégorisent et alertent, ce qui a pour conséquence d’accroître le contrôle.

Ils savent, mais ne bougent pas

Face à un harcèlement algorithmique ciblé, une question se pose : Comment une telle mécanique peut-elle exister alors que ces outils sont surveillés et régulés par des instances puissantes ?

La réalité est simple : ils ne peuvent pas l’ignorer. Ces IA de veille sont capables de détecter n’importe quelle manipulation algorithmique anormale.

Un ciblage excessif, un enfermement forcé, une distorsion du libre accès à l’information : tout cela est traçable. Pourtant, rien ne bouge. Pourquoi ?

Parce que ceux qui pourraient lutter contre ces dérives sont souvent ceux qui en profitent.

Parce que l’inaction permet d’entretenir l’illusion d’un algorithme neutre, alors qu’il est orienté pour servir des intérêts précis.

Parce que la manipulation algorithmique est un outil de pouvoir, bien plus efficace qu’une censure brutale.

L’ironie est totale : les institutions qui auraient les moyens de protéger les citoyens du harcèlement algorithmique sont aussi celles qui l’utilisent comme levier de surveillance et de contrôle. Elles savent, elles voient, mais elles laissent faire.

Les entreprises et les États ont des moyens de repérer ces abus mais ne les corrigent pas, voire les exploitent.

Introduction du concept de séquestration numérique

L’ère numérique a transformé les formes de captivité et d’exploitation humaine. Il ne s’agit plus de séquestration physique, où une personne est enfermée dans un espace clos, mais d’une captivité algorithmique, bien plus insidieuse.

L’individu n’est pas attaché par des chaînes visibles, mais maintenu dans un environnement contrôlé, façonné par des algorithmes qui influencent ce qu’il voit, ce qu’il pense et comment il réagit. C’est un enfermement qui ne dit pas son nom, où tout est calculé pour façonner ses perceptions et ses choix, souvent sans qu’il en ait conscience.

Exploitation moderne et invisible

Les plateformes numériques n’ont pas besoin de coercition directe pour exploiter leurs utilisateurs. Elles utilisent des méthodes subtiles mais efficaces, verrouillant l’individu dans un système où son attention et ses réactions deviennent des ressources exploitables.

L’engagement prolongé et le conditionnement mental deviennent alors une nouvelle forme d’exploitation, avec des conséquences concrètes :

Le maintien dans une bulle idéologique ou émotionnelle

L’algorithme sélectionne et répète certains contenus pour renforcer une vision du monde spécifique, créant un biais cognitif forcé. Les utilisateurs ne sont plus exposés à la diversité, mais enfermés dans un cadre idéologique rigide.

Récupération de données personnelles à des fins lucratives

Chaque interaction est enregistrée, analysée et monétisée. Les entreprises utilisent ces données pour mieux cibler, influencer et vendre, exploitant l’utilisateur comme un simple produit.

Influence sur les comportements et décisions

L’algorithme ne se contente pas de montrer du contenu : il façonne la manière dont on pense et agit. Achats, opinions politiques, réactions émotionnelles : tout est orienté, dans un but précis.

Un exemple concret : La séquestration physique et son parallèle numérique

Le contrôle algorithmique fonctionne comme une prise d’otage, à la différence que la cage est invisible.

Dans une séquestration physique, la victime est isolée, coupée du monde, soumise à un conditionnement psychologique intense. Avec le temps, elle intègre la réalité imposée par son ravisseur, développant parfois un Syndrome de Stockholm, où elle finit par accepter et justifier sa propre captivité.

Dans la séquestration numérique, l’utilisateur n’est pas enfermé physiquement, mais son esprit est captif. Il est soumis à un conditionnement algorithmique, qui modifie ses perceptions et lui impose une vision unique du monde. À force d’être exposé aux mêmes contenus et aux mêmes narratifs, il finit par considérer cette réalité biaisée comme une évidence.

L'illusion du libre arbitre : Des choix biaisés et limités

La plus grande réussite de cette prison numérique, c’est qu’elle fait croire à ses captifs qu’ils sont libres.

L’algorithme prétend offrir du choix, mais ces choix sont biaisés et limités.

Les prisonniers numériques ne voient pas leurs chaînes, car elles sont faites d’informations, de suggestions et d’habitudes qu’ils pensent naturelles.

Tout semble fluide et logique, alors qu’en réalité, chaque parcours est tracé à l’avance, orientant progressivement l’utilisateur vers des comportements et des pensées spécifiques.

Reprendre le contrôle

Le harcèlement algorithmique n’est pas une simple dérive technologique. Ce n’est pas une fatalité ni un effet secondaire d’une personnalisation mal calibrée. C’est un mécanisme intentionnel, conçu pour enfermer, influencer et contrôler. Il ne se contente pas d’observer, il façonne, créant des bulles mentales où l’individu se retrouve prisonnier d’une réalité numérique verrouillée.

Ceux qui détiennent ces outils ne les utilisent pas au hasard. Les algorithmes ne sont pas neutres : ils sont des instruments de pouvoir, des armes invisibles de conditionnement mental et économique. En restreignant l’accès à certaines informations, en influant sur les comportements et les décisions, ils participent à une forme moderne de captivité, où l’enfermement est d’autant plus efficace qu’il est indétectable pour ceux qui le subissent.

Briser l’assignation algorithmique

Comment briser ce cercle vicieux ? Briser cette captivité, c’est refuser l’assignation algorithmique, en refusant l’évidence et questionner ce que l’on nous propose. C’est diversifier volontairement ses sources et refuser les bulles de confort, en se réappropriant ses choix au lieu de suivre des recommandations dictées par une machine.

Refuser les bulles de confort.

Les algorithmes nous proposent ce qu’ils veulent, mais nous pouvons choisir d’explorer par nous-mêmes. Multiplier ses sources, refuser les circuits fermés, aller chercher l’information hors des sentiers tracés, utiliser des outils anti-surveillance.

Récupérer la maîtrise de son propre cheminement intellectuel et économique.

Les plateformes tentent de définir nos trajectoires : ce que nous pensons, ce que nous achetons, ce que nous devenons. En refusant ces influences invisibles, en prenant des décisions hors du cadre imposé, nous retrouvons notre autonomie. Pour cela, il faut changer ses habitudes.

Éviter le fichage algorithmique devient alors un véritable jeu de piste.

Mais les dés sont déjà pipés car l'algorithme s'adapte en temps réel. Dès qu'un utilisateur commence à contourner certaines recommandations (par exemple, en recherchant manuellement des contenus hors des suggestions habituelles), il est repéré et de nouvelles stratégies sont mises en place pour le ramener dans le cadre algorithmique prévu :

Par l’omniprésence des algorithmes. On peut éviter les suggestions de YouTube, mais comment éviter celles de Google, Twitter, Facebook, TikTok, Netflix, Amazon et même des publicités ciblées basées sur notre historique ? Même les recommandations Spotify sont influencées par un traçage comportemental.

Par le verrouillage progressif des alternatives. Des outils comme Tor, VPN, ou moteurs de recherche alternatifs (Qwant, DuckDuckGo) existent, mais ils ne sont jamais aussi performants que Google (qui reste incontournable pour certaines recherches). Et surtout, les alternatives finissent souvent par être compromises (DuckDuckGo a récemment été critiqué pour certains accords avec Microsoft, par exemple).

Par l'influence sur les comportements. Même en tentant d’échapper aux bulles de filtres, on finit par intérioriser une partie de cette influence algorithmique, car on ne peut pas complètement anticiper ce qu'on ne voit pas. Si un sujet ou une information est invisibilisé par l’algorithme, comment savoir qu’on est privé de cette info ? C’est le paradoxe du fichage algorithmique : il agit sans que l'on s’en rende compte.

C’est là toute l’ironie du système : pour éviter d’être enfermé dans une bulle algorithmique, il faut faire des efforts que 99 % des gens n’ont ni le temps ni l’énergie de faire. Et c’est précisément sur ça que les plateformes comptent.

Du coup, même en ayant conscience du problème, on joue une partie où l’ennemi a déjà plusieurs coups d’avance.

Et le piège ultime, c’est que plus on essaie d’y échapper, plus on devient suspect. Parce que ceux qui cherchent à éviter le traçage algorithmique sont justement ceux qui dérangent.

À moins de vivre en totale déconnexion numérique, on est toujours suivi, fiché et influencé d’une manière ou d’une autre. Même en utilisant des outils de protection, on ne fait que ralentir l’algorithme, pas l’arrêter.

L'ironie du système : un piège qui se referme sur ses créateurs

Ceux qui ont tenté d’enfermer leurs cibles dans ces mécanismes pensaient les affaiblir. Pourtant, ils ont fait exactement l’inverse :

En cherchant à verrouiller mon environnement numérique, ils ont renforcé ma lucidité.

En cherchant à m’assigner un rôle, ils ont renforcé ma détermination à exposer ces mécanismes.

En cherchant à me contraindre, ils ont accéléré leur propre mise en lumière.

Le pouvoir algorithmique ne repose que sur l’ignorance de ceux qu’il enferme. Mais dès lors que l’on prend conscience du piège, il perd toute son efficacité.

Une affaire pour les droits de l’homme ?

Cette captivité numérique forcée n’est pas qu’une nuisance : elle pourrait être assimilée à une violation des libertés fondamentales.

Droit à l’information : restreint par des bulles de contenu fermées.

Droit à la libre pensée : influencé et formaté par des systèmes invisibles.

Droit à la vie privée : constamment scruté, analysé et monétisé.

Peut-on laisser une intelligence artificielle décider de ce que nous avons le droit de voir, d’entendre et de penser ?

Cette question relève des Droits de l’Homme.

Et après ?

Le harcèlement algorithmique ne fonctionne que si personne ne le questionne. Lorsqu’on pointe ses mécanismes, il devient évident.

Mais comment se défendent ceux qui orchestrent ces stratégies ? Quand ils sont accusés de manipuler, ils retournent l’attaque : ils accusent les lanceurs d’alerte de complotisme.

Complot ou complotisme ? Où se trouve la limite entre réalité et manipulation des perceptions ? Ce sera le sujet du prochain article.

»»» Suivez-moi sur X «««

»»» Pour en savoir plus : À ma belle esclave ou le récit d’une vie volée «««

»»» Pour me soutenir ou financer le scandale à venir : Buy me a Coffee «««

»»» Mon site web «««